Systemkonzept für zukünftige Multimedia Systeme mit dynamisch skalierbaren Algorithmen

Prof. Dr.-Ing. habil. Christian Hentschel

Zukünftige Consumer Terminals (TV's, Set-Top Boxen, Displays und mobile Geräte) werden hochwertige Video und Audioapplikationen mit Multimediaanwendungen aus dem PC Bereich verbinden. Die Basis bilden programmierbare Plattformen, die Media Signalverarbeitung in Software erlauben. Die erwarteten Vorteile sind flexible, zukunftssichere und offene, erweiterbare Produkte, kurze Zeit zur Markteinführung neuer Dienste und die Wiederverwendung von Hardware und Software zur Unterstützung von Produktfamilien.

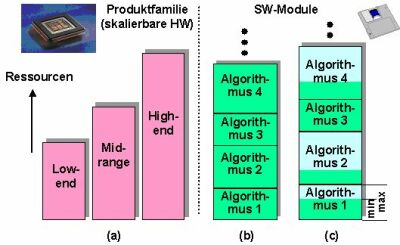

Programmierbare Komponenten sind sehr kostspielig und verbrauchen derzeit mehr Energie im Vergleich zu funktionsspezifischen Realisierungen. Dazu kommt, dass Consumer Terminals aus Kostengründen stark in ihren Ressourcen begrenzt sind. Unsere Forschungsergebnisse zeigen, dass diese Nachteile durch Skalierbare Video Algorithmen (SVA's) überwunden werden, die die programmierbaren Komponenten sehr effizient und flexibel nutzen können (Bild 1).

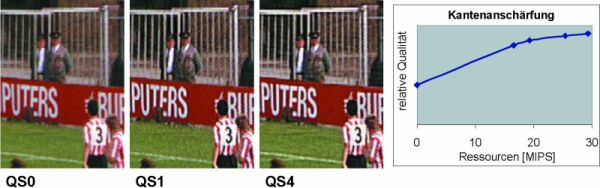

SVA's sind Algorithmen, die sich dynamisch in ihrer Ausgangsqualität in Relation zu den zur Verfügung stehenden Ressourcen steuern lassen. Die dynamische Kontrolle der Qualität und genutzten Ressourcen ist in traditionellen Systemen unbekannt. Als Beispiel wird ein skalierbarer Algorithmus zur Kantenanschärfung in Bild 2 vorgestellt. Da ein Ausgangsbild bereits ohne Signalverarbeitung verfügbar ist, benötigt die Basisfunktion QS0 keine Ressourcen. Der Algorithmus ist somit 100% skalierbar. Bei QS1 findet lediglich eine horizontale Bildschärfeanhebung statt, was im Tor deutlich zu sehen ist. Fast horizontale Linien wie die Linien im Feld werden nicht angeschärft. Bei dieser einfachen Verarbeitung (ca. 17 MIPS für normale Standardauflösung) wird Bildrauschen leider ebenfalls verstärkt, was im Rasen erkennbar ist. Aufwendigere Signalverarbeitung (QS4) verwendet zweidimensionale Filter und Schutzmechanismen gegen Rauschen und Clipping. Der Ressourcenbedarf steigt auf 29 MIPS an.

Diese Forschungsarbeiten wurden weltweit bei Philips Research durchgeführt, wobei Prof. Hentschel wesentliche Koordinierungs- und Leitungsaufgaben übernahm. Er ist an zahlreichen Schlüsselpatenten beteiligt und wird sich auch in Zukunft mit diesem Thema beschäftigen.

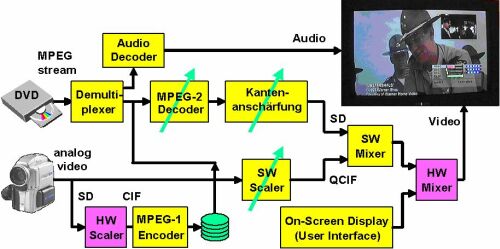

Das entwickelte neuartige Systemkonzept ermöglicht komplexe Applikationen auch auf programmierbaren Plattformen (DSP's) mit begrenzten Ressourcen. Die erste Echtzeitimplementierung (Bild 3) auf einem VLIW-DSP (TriMedia 1300) beinhaltet skalierbare Algorithmen (MPEG-2 Video Decoder, Kantenanschärfung, Picture-in-Picture), nichtskalierbare Algorithmen (Demultiplexer, Audio Decoder, SW Mixer, HW Mixer, MPEG-1 Encoder) und Kontrollmodule (Strategie Manager, QoS Ressource Manager, Graphikeinblendung mit Leistungsmessung). Verschiedene Applikationen wurden implementiert, z.B. MPEG-2 Decodierung plus Kantenanschärfung, oder zusätzlich Picture-in-Picture von einer zweiten Quelle und MPEG-1 Aufzeichnung, alle zur gleichen Zeit. Die Ergebnisse bestätigen in eindrucksvoller Weise die Vorteile dieser neuartigen Technologie.