Teilprojekte mit BTU Beteiligung

Motivation:

Diese Forschungsarbeit schlägt einen integrierten Ansatz zum Verständnis und zur Vorhersage von Schäden an den Spitzen von deckbandlosen Hochdruckturbinenschaufel vor. Durch die Korrelation von experimentellen Beobachtungen mit multiphysikalischen Simulationen zielt die Forschung darauf ab, die zugrunde liegenden Mechanismen der Rissbildung und des Risswachstums aufzudecken und damit die Vorhersagegenauigkeit im Vergleich zu rein simulationsbasierten Methoden zu verbessern.

Ansatz:

Säule 1. Erkennung, Quantifizierung und Kategorisierung von Oberflächenrissen in Turbinenschaufeln

• Deep-Learning-gestützte Erkennung von Oberflächenrissen unter Verwendung eines maschinellen Lernmodells mit Pixelgenauigkeit

• Quantifizierung und Kategorisierung von Rissen

• Datengestützte Bewertung von Turbinenschaufelsätzen

Säule 2: Definition des Rissmechanismus mittels multiphysikalischer Finite-Elemente-Analyse (FEA)

• Rissbildung aufgrund von Kriechen, Eigenspannung und Oxidation. Rissausbreitung

Säule 3. Integrierter Ansatz zur Schadensvorhersage an Hochdruckturbinenschaufelspitzen

• Korrelation der FEA-Ergebnisse mit festgestellten Rissen

• Untersuchung der rissauslösenden Parameter

• Identifizierung schädlicher Betriebsbedingungen

Ergebnisse:

Deep-Learning-gestützte Oberflächenrisserkennung unter Verwendung eines maschinellen Lernmodells mit Pixelgenauigkeit

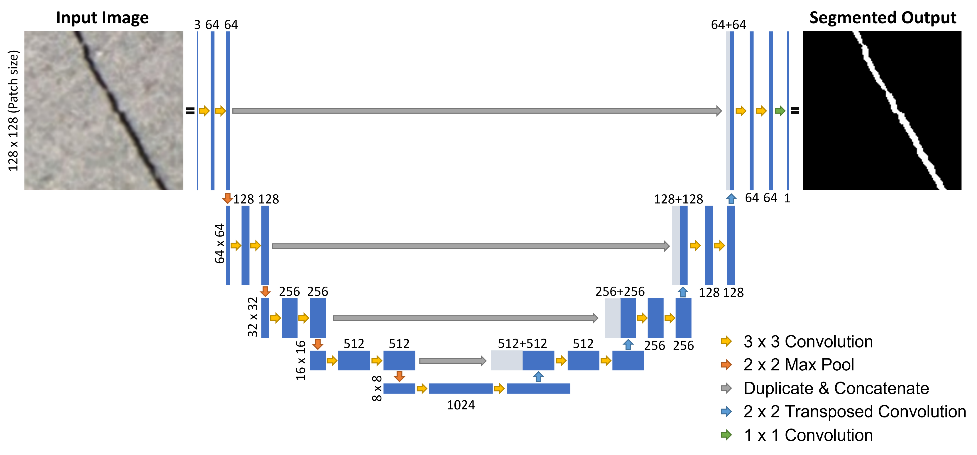

1. Angewandtes Modell zur Risserkennung: U-Net

U-Net ist ein CNN basiertes Künstliche Intelligenz (KI) Modell, das für die pixelgenaue Bildsegmentierung (Erkennung von Rissen, Tumoren, Blutgefäßen usw.) entwickelt wurde. Im Gegensatz zu klassischen Klassifizierungsmodellen lokalisiert U-Net nicht nur Objekte, sondern generiert detaillierte Pixelmasken, die exakt die Konturen der gesuchten Strukturen abbilden.

2. Das Segmentierungsframework zerlegt vollständige Bilder von Turbinenschaufelspitzen in 128×128-Pixel-Patches und führt eine Klassifizierung auf Pixelebene durch, um rissige Bereiche von intakten Oberflächen zu unterscheiden. Das Modell erreicht:

• > 99,5 % Genauigkeit (einschließlich nicht rissiger Pixel),

• ~ 85 % Recall (True-Positive-Rate für die Risserkennung) und ~ 85 % Präzision (Anteil der vorhergesagten Risse, die gültig sind).

AP1.5 - Modellierung von CMAS Partikel Aufbau und Interaktion mit heißen

Oberflächen in der Turbine

Leitung BTU: Prof. Dr.-Ing. Michael Oevermann

Mitarbeiter BTU: Ravishankar Selvaraj

Partner RR: Dr. Andreas Vogel

Motivation/Hintergrund

Flugrouten verlaufen manchmal durch Bereiche der Atmosphäre mit einer hohen Konzentration an Partikeln, wie Sand- oder Vulkanaschepartikeln. Die Wechselwirkung dieser sogenannten CMAS-Partikel (Calcium, Magnesium, Aluminium, Silikat) mit heißen Turbinenoberflächen führt zur Bildung fester Schichtablagerungen, die die Geometrie der Turbinenschaufeln hinsichtlich Form und Oberflächenrauheit verändern. Diese Veränderungen haben erhebliche negative Auswirkungen auf die Leistung der Triebwerke und verringern die Lebensdauer sowohl der Triebwerke als auch ihrer Komponenten. Derzeit existiert kein simulationsbasiertes Verfahren, um diese Wechselwirkungen während des Entwurfs- und Zertifizierungsprozesses vorherzusagen und zu bewerten.

Zielsetzung

Das Ziel dieses Arbeitspakets ist zweifach. Erstens soll ein CFD-Modell (Computational Fluid Dynamics) entwickelt und implementiert werden, um die Partikelablagerung auf heißen Turbinenkomponenten vorherzusagen. Dabei werden wichtige physikalische Parameter wie Aufprallgeschwindigkeit, Aufprallwinkel, Temperatur, Viskosität usw. berücksichtigt. Zusätzlich werden weitere notwendige Modelle integriert, die eine wichtige Rolle bei der Partikelhaftung spielen, wie Phasenänderungen der Partikel, Bildung von Oberflächenschichten und resuspension . Zweitens zielt das Arbeitspaket darauf ab, diesen Modellierungsansatz hinsichtlich seiner Anwendbarkeit im Entwurfs- und Zertifizierungsprozess zu evaluieren.

Lösungsansatz

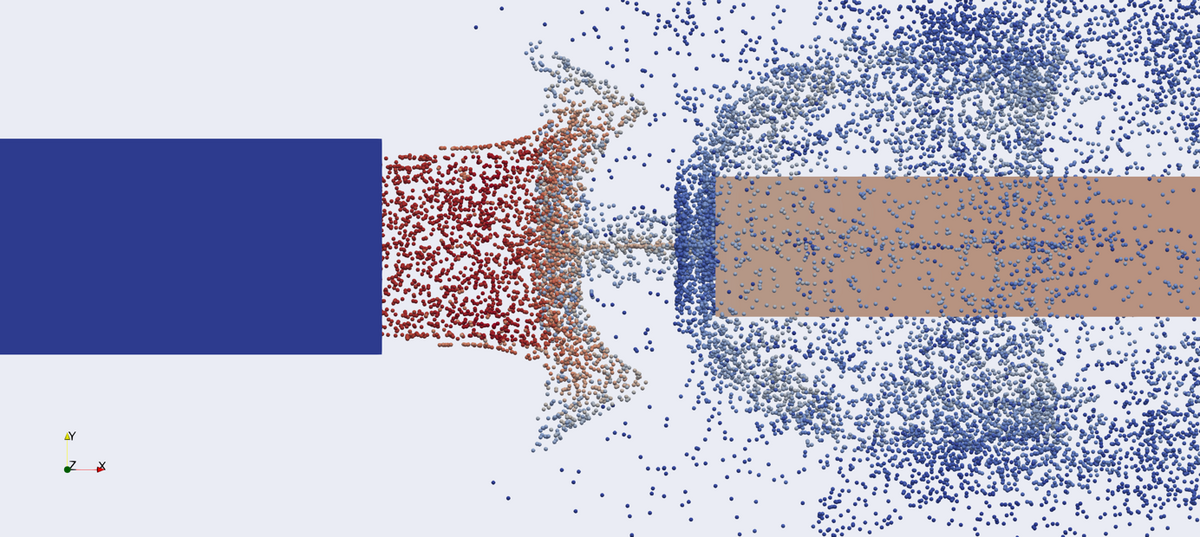

Zur Simulation von Partikelwechselwirkungen mit Turbinenkomponenten wird ein Euler-Lagrange-CFD-Ansatz verwendet. Abbildung 1 zeigt ein Beispiel für eine solche Simulation. Die Bahnen einzelner oder repräsentativer Partikel werden nach den Newtonschen Bewegungsgesetzen berechnet, was eine detaillierte Modellierung der Partikelwechselwirkungen mit Turbinenkomponenten ermöglicht. In diesem Rahmen werden thermodynamische, konstitutive und kinetische Aspekte der Partikel-Wand-Wechselwirkungen berücksichtigt.

Zur Modellierung von Partikeladhäsion wird ein Ansatz basierend auf einer sogenannten „Sticking-Probability“ verwendet, der gute Übereinstimmung mit experimentellen Ergebnissen gezeigt hat. Um die Genauigkeit weiter zu verbessern und das reale Partikelverhalten besser nachzubilden, werden zusätzlich Faktoren wie kritische Viskosität, variabler Restitutionskoeffizient, energiebasierte Modelle und Oberflächenspannungseffekte einbezogen.

AP2.3 - Simulationsdatenkompression und -rekonstruktion mit neuronalen Netzen

Leitung BTU: Prof. Dr.-Ing. Michael Oevermann

Mitarbeiter BTU: Abishek Dhiman

Partner RR: Dr. Axel Gerstenberg, Alexander Hardenberg

Motivation/Hintergrund

Komplexe, zeitabhängige dreidimensionale Simulationen (z.B. Finite Elemente (FEM), Computational Fluid Dynamics (CFD)) sind integraler Bestandteil industrieller Forschung und Entwicklung. Aktuelle Höchstleistungsrechner erlauben Simulationen mit extremer Detailtiefe und Vorhersagekraft zum Preis von Datenmengen, die mit aktuellen Prozessketten nicht sinnvoll genutzt werden können.

Zielsetzung

In diesem Arbeitspaket soll eine Prozesskette zur Analyse und Visualisierung extrem großer, zeitabhängiger Simulationsdaten entwickelt werden, bei der Datenkompression und -rekonstruktion mit neuronalen Netzen erfolgt. Die Visualisierung soll mittels Virtual Reality unterstützt werden.

Lösungsansatz

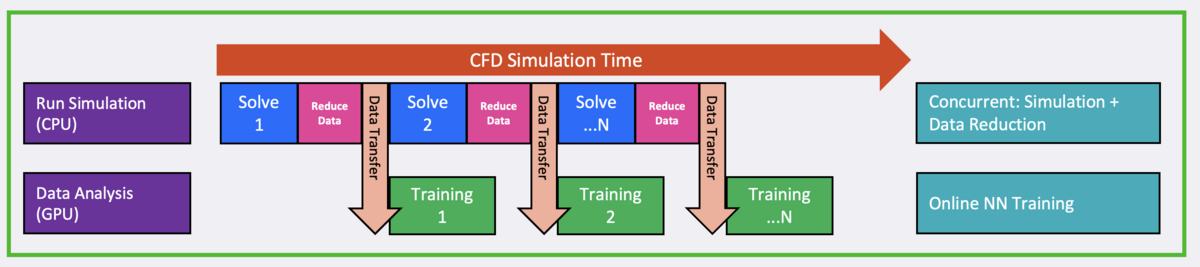

Als Lösungsansatz wird die in Abb. 1 dargestellte hybride In-Situ In-Transit Prozesskette zur Datenanalyse implementiert. Wesentliche Merkmale, die zu einer effizienten Nutzung von Resourcen führen, sind:

Gleichzeitige Simulation und Datenanalyse (In-Situ)

Nutzung separater Resourcen für Simulation und Datenanalyse (In-Transit), hier: CPU Cluster für die Simulation, GPU Cluster zur Datenanalyse

Kein File I/O, Datenreduktion vor Datentransfer (Hybrid)

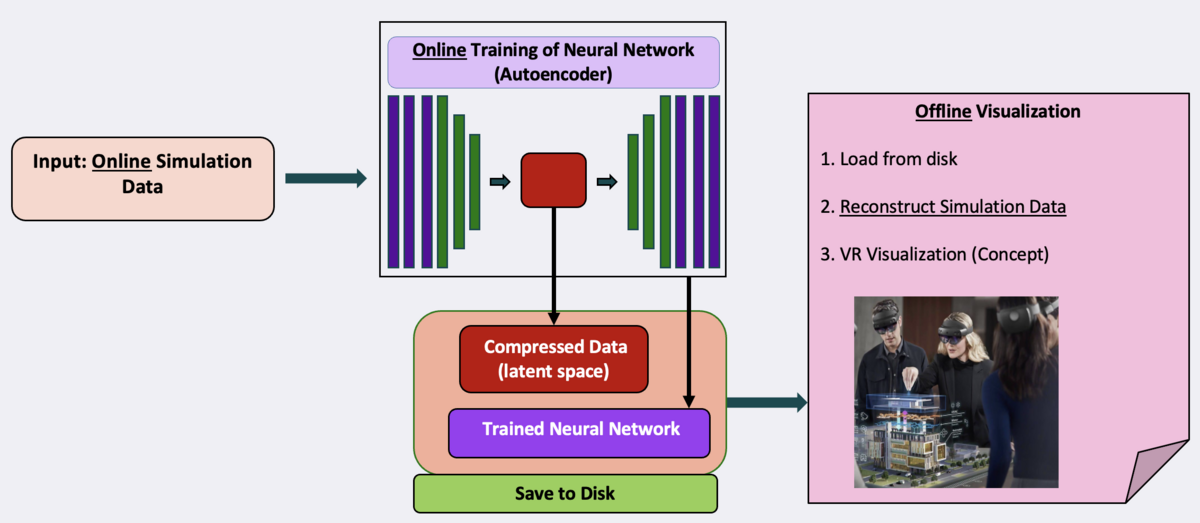

Die Datenanalyse besteht hier in der Datenreduktion und -rekonstruktion mit neuronalen Netzen, die in Abb. 2 am Beispiel eines Autoencoders dargestellt ist. Die Herausforderung besteht darin, mit den verfügbaren Ressourcen ein Online-Training der neuronalen Netz Architektur realisierten zu können, die eine Datenkomprimierung mit hinreichender Qualität in der Frequenz der einkommenden Daten ermöglicht. Die komprimierten Daten werden gespeichert und können in weiteren Prozessschritten, z.B. für die Visualisierung, genutzt werden.

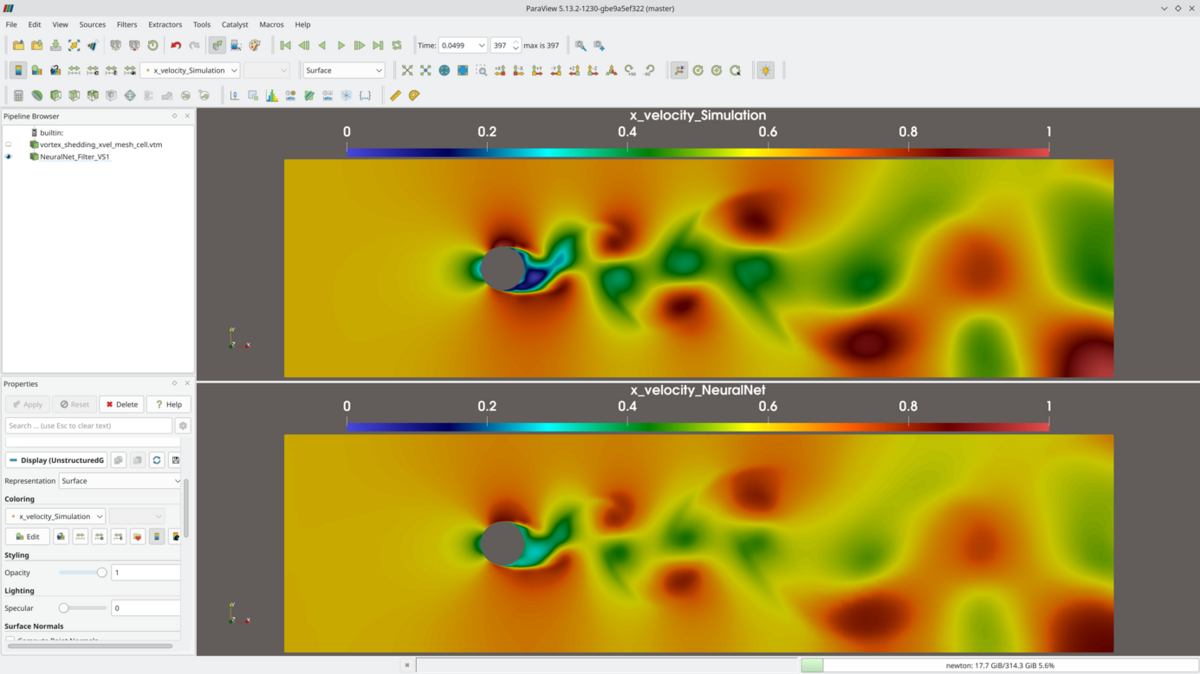

Preliminary Results

Abb 3. zeigt im oberen Teil die originalen Simulationsdaten und im unteren Teil die mittels Autoencoderarchitektur rekonstruierten Daten am Beispiel der Wirbelablösung hinter einem Zylinder.

VIT IV AP 3.5A - Wissensrepräsentation und Kausalitätsanalyse zur beschleunigten Fehlerlokalisierung für die Produktion

Für die Herstellung und Auslieferung von Flugzeugtriebwerken ist es entscheidend Anomalien und deren Ursachen möglichst frühzeitig im Produktionsprozess zu erkennen. Schon kleinste Abweichungen in den Vibrationsmustern, wie sie während der Pass-Off Tests auftreten können, weisen häufig auf Fertigungsungenauigkeiten, Montageabweichungen oder beginnende Defekte hin. Werden solche Auffälligkeiten erst spät oder erst im Betrieb entdeckt, entstehen hohe Folgekosten durch Nacharbeit, außerplanmäßige Wartung oder, im schlimmsten Fall, sicherheitskritische Vorfälle.

Die Kombination aus automatisierter Anomalieerkennung und Kausalitätsanalyse ermöglicht es, diese Risiken signifikant zu reduzieren. Anomalien können nicht nur schneller identifiziert, sondern auch ihre Ursachen besser verstanden werden. Dadurch lassen sich zielgerichtete Korrekturmaßnahmen im Produktionsprozess einleiten, die Qualitätssicherung verbessern und die Betriebssicherheit langfristig erhöhen. Dies führt gleichzeitig zur Steigerung der Wirtschaftlichkeit, da Ausfallzeiten und kostenintensive Rückrufaktionen vermieden werden.

Ziel dieses Arbeitspaketes soll das Erforschen effizienter Methoden aus dem Bereich der künstlichen Intelligenz und des maschinellen Lernens zur Erkennung und Analyse anomalen physikalischen Verhaltens sein. Im Zentrum steht dabei die Nutzung multimodaler Datenquellen, wie etwa Vibrations-, Druck-, Temperatur- oder Strömungsdaten, die in Pass-Off Tests erhoben werden. Durch die gemeinsame Auswertung dieser unterschiedlichen Datenkanäle können Anomalien nicht nur zuverlässiger erkannt, sondern auch komplexe Zusammenhänge zwischen verschiedenen physikalischen Größen aufgedeckt werden. Ein besonderer Schwerpunkt liegt hierbei auf der kausalen Analyse, um neben der reinen Anomaliedetektion auch die zugrunde liegenden Ursachen systematisch zu identifizieren.

Die Ergebnisse sollen langfristig dazu beitragen, mögliches anomales Verhalten und seine wahrscheinlichen Ursachen bereits im Fertigungsprozess vorherzusagen.